Tutorials & Guides

Search Post

Recent Posts

DX Consulting in German and English

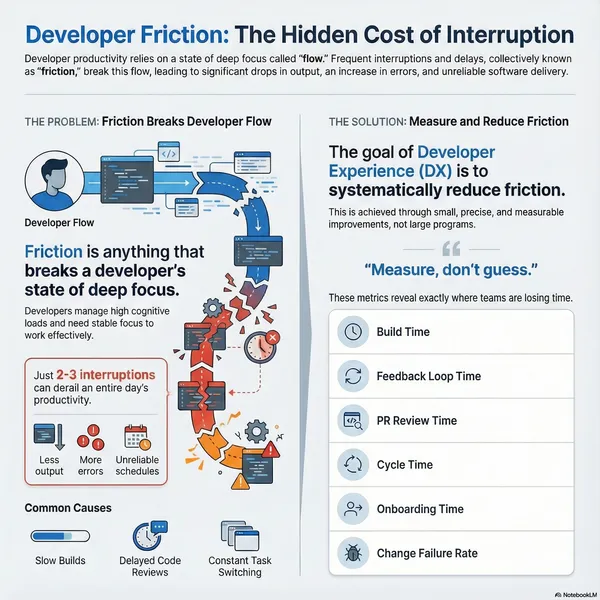

Ready to improve developer productivity?

Let’s discuss how I can help your team reduce friction, improve delivery performance, and establish a measurable, stable development workflow. All services are available in German and English.

000 +

Years of Experience